在 Google I/O 2024 开发者大会上,谷歌宣布,它正在努力通过将其最小的 Gemini 模型 Gemini Nano 引入 Chrome,实现对设备上大型语言模型的支持。

Chrome 开发人员 Kenji Baheux 和 Alexandra Klepper 表示,生成式 AI 需要使用比网页大小中位数大一千倍的大型模型,范围从 10 兆字节到 100 兆字节不等。

虽然这使得在设备上本地部署和运行 AI 模型变得相当困难,但这样做的好处是多方面的,包括为敏感数据提供更好的隐私,这些数据不需要离开用户的设备;减少延迟以改善用户体验;离线访问 AI 功能,并在远程模型不可用时优雅地回退;以及混合计算方法的可能性,您可以在设备上运行一些 AI 作为预览,或降低频繁用户流的远程推理成本。

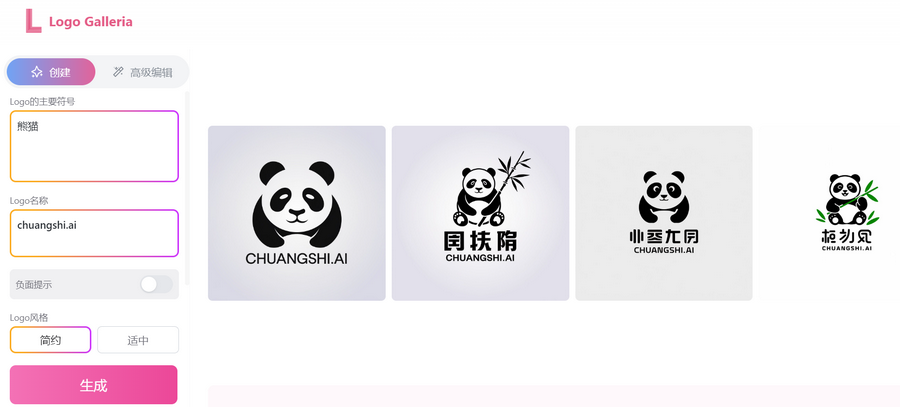

目前此功能仅在 Chrome Canary 版中测试,下载的 Gemini Nano 模型体积约为 1.4GB 左右,解压后的模型大小为 1.74GB,成功启用模型后可以在 F12 控制台中运行。有兴趣的用户可以安装 Chrome Canary 进行测试,下面是启用方法:

1.在浏览器地址栏输入下面内容启用BypassPerfRequirement

chrome://flags/#optimization-guide-on-device-model2.在浏览器地址栏输入下面内容启用Nano

chrome://flags/#prompt-api-for-gemini-nano3.在浏览器地址栏输入下面内容检查模型

其中 Optimization Guide On Device Model 即为模型,目前最新版本为 2024.6.5.2205,如果已经成功下载则这里会显示版本号。如果没有显示模型组件,请禁用第 1、2 步的设置然后重启浏览器再重新启用。

chrome://components/4.当模型下载完成后按 F12 进入控制台输入 window.model.createTextSession () 如果没有报错那就是启用成功。

![谷歌在Chrome浏览器中内置AI模型可以本地对话[附开启方法]-创世AI](https://img.snailshub.com/images/2024/08/09/gemini.png)

![还不会写Gemini提示词吗?Google帮你整理了一份提示词宝库[官方]-创世AI](https://www.chuangshi.ai/wp-content/uploads/2024/09/gemini.png)

暂无评论内容